Conheça o Nightshade, ferramenta que promete defender artistas do mundo todo contra a IA generativa.

As IAs generativas estão na moda, simulam conversas, textos, roteiros, TCCs, imagens, vídeos e muito mais apenas com um comando. O problema é que a IA não tira estar informações do nada e a ferramenta acaba plagiando imagens, textos e estilos únicos de cada artista sem lhes dar crédito ou compensação financeira. Mas o Nightshade promete mudar pelo menos um pouco isso.

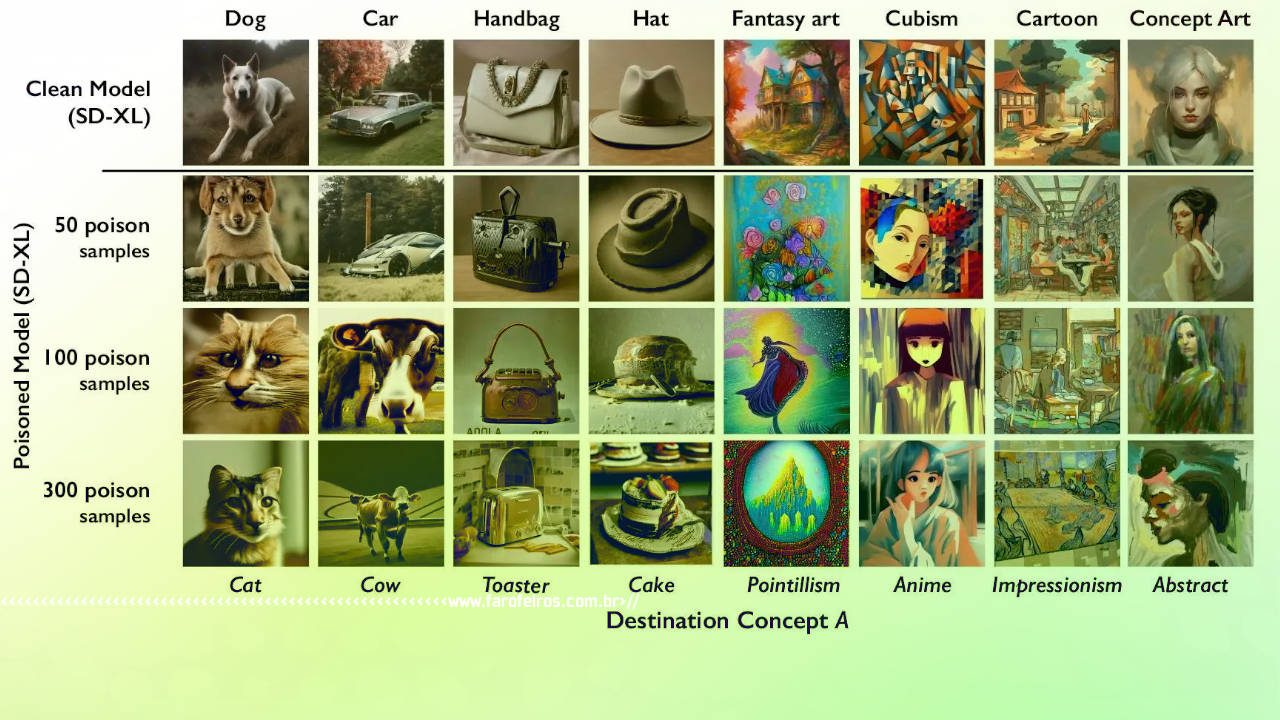

A ideia por trás do sistema do Nightshade é adicionar pixels invisível antes dela ser enviada para a internet. Se uma IA generativa faz seu “treinamento” utilizando aquela imagem ocorro o chamado “envenenamento”, quebrando o modelo da IA em maneiras imprevisíveis. As informações são do MIT Technology Review.

Até o momento apenas IAs que geram imagens estão na mira da ferramenta. DALL-E, Midjourney, Stable Diffusion e outras já foram “vítimas” do sistema criado por estudantes da University of Chicago. Além da Nightshade a equipe criou também a ferramenta Glaze que permite que artistas mascarem seu estilo pessoal de IAs em “treinamento”.

Companhias como OpenAI, Meta, Google, Stability AI entre muitas outras, estão recebendo constantes processos por uso indevido de imagens sem consentimento ou compensação.

As marcações nas imagens das ferramentas Nightshade e Glaze são praticamente invisíveis ao olho humano. Pelo menos já é uma ferramenta que pode ajudar artistas do mundo todo, mesmo assim, é importante apontar, que são necessárias milhares de imagens “envenenadas” para efetivamente atrapalhar as IAs.

Aparentemente utilizar esse tipo de ferramenta, que envenena os modelos modernos de machine learning, é o que irá defender pequenos criadores de se tornarem mais uma vítima de roubo.

Para mais informações e para download do Nightshade basta acessar o site oficial.

Deixe um comentário